武汉大学x时识科技cvpr联合发文:基于事件流与图像

近日,IEEE CVPR 2022(2022年国际计算机视觉和模式识别会议)发布了论文录用结果,武汉大学电子信息学院余磊副教授实验团队携手SynSense时识科技在合成孔径成像领域的工作《基于事件流与图像帧的合成孔径成像》(Synthetic Aperture Imaging with Events and Frames)被大会录用。

据悉,IEEE CVPR 是计算机视觉与模式识别领域的顶级学术会议,论文录用率不到25%,是人工智能领域最具影响力的国际学术会议之一,并被中国计算机学会认定为A类会议。

武汉大学电子信息学院副教授、博士生导师余磊长期从事信号与信息处理相关领域的研究,目前主要研究稀疏信号处理、类脑视觉感知和信息表征处理,在相关领域顶级期刊和会议上发表论文50余篇,在CVPR 2021,其论文被选为最佳论文候选。

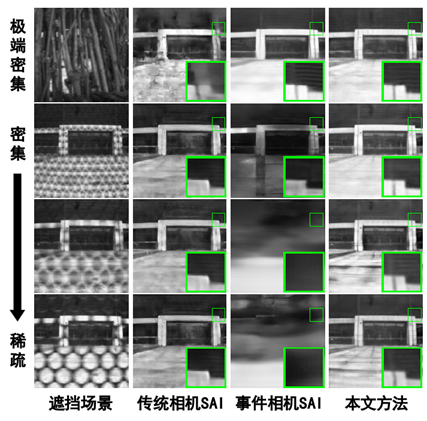

此次余磊副教授团队与时识科技联合发表的合成孔径成像(SAI)技术,对遮挡场景进行多视角观拍摄,并通过对焦与合成实现对被遮挡目标的成像,在机器人、自动驾驶等领域具有非常重要的应用价值。

考虑到传统相机受限于低帧率和低动态范围,余磊副教授实验团队于2021年首次提出了基于事件相机的合成孔径成像系统,使用高动态范围、低延时的仿生传感器事件相机解决密集遮挡与极端光照场景中的合成孔径成像问题,该论文已被收录于CVPR 2021。

然而,基于事件相机的SAI系统在稀疏遮挡场景中由于事件点数据减少而出现性能退化。针对这一问题,此次论文提出了一种基于事件相机与传统相机的合成孔径成像系统,互补地融合事件流与图像帧数据并重建遮挡目标图像。

其中,为了解决事件流与图像帧存在的数据模态差异问题,该论文提出了一种混合网络(脉冲神经网络+卷积神经网络),从多模态数据中提取目标特征并互补地进行融合与亮度重建,从而实现了对遮挡场景鲁棒的高质量合成孔径成像系统。相对于基于传统相机或事件相机的合成孔径成像系统,论文提出的方法在多种密集程度遮挡中均能实现高质量目标成像。

目前相关代码已在github主页开源:https://github.com/smjsc/EF-SAI

持续进行基于类脑智能的新技术研发,长久以来,SynSense时识科技联合中外顶级高校及研究所,在建立更活跃类脑研究交流生态的同时,不断探索类脑技术在包括自动驾驶等前沿领域的相关应用,旨在赋能现有智能设备,并为未来智能应用带来颠覆性提升。